最近,一场机器阅读理解考试的最新成绩新鲜出炉——由斯坦福大学发起的SQuAD(Stanford Question Answering Dataset)挑战赛榜单更新成绩,科大讯飞与哈工大联合实验室(HFL)提交的系统模型夺得第一名,这也是中国本土研究机构首次取得该赛事的榜首。

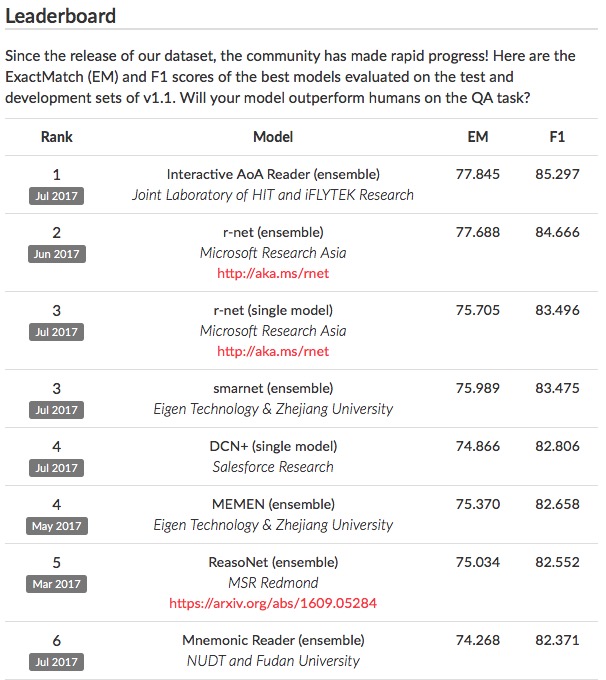

▲ 斯坦福SQuAD最新排名

▲ 斯坦福SQuAD最新排名

SQuAD挑战赛是行业内公认的机器阅读理解标准水平测试,也是该领域的顶级赛事,被誉为机器阅读理解界的ImageNet(图像识别领域的顶级赛事)。参赛者来自全球学术界和产业界的研究团队,包括微软亚洲研究院、艾伦研究院、IBM、Salesforce、Facebook、谷歌以及卡内基·梅隆大学、斯坦福大学等知名企业研究机构和高校,赛事对自然语言理解的进步有重要的推动作用。

阅读理解题,机器怎么考?

阅读理解是人类考试中必不可少的项目之一,对于机器,又该怎样去作答和评判呢?

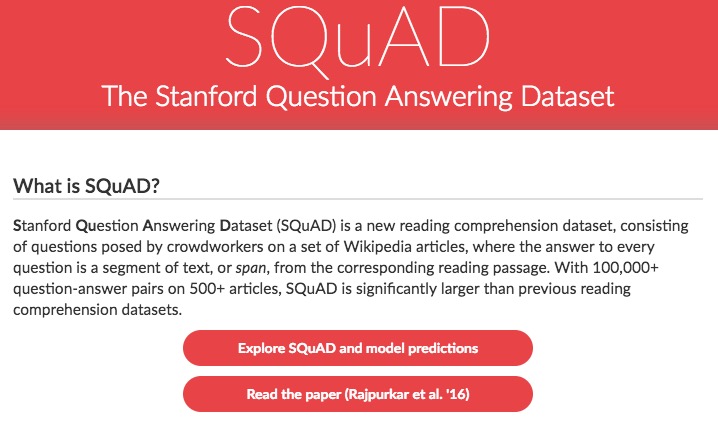

SQuAD挑战赛通过众包的方式构建了一个大规模的机器阅读理解数据集(包含10万个问题),就是将一篇几百词左右的短文给人工标注者阅读,让标注人员提出最多5个基于文章内容的问题并提供正确答案;短文原文则来源于500多篇维基百科文章。参赛者提交的系统模型在阅读完数据集中的一篇短文之后,回答若干个基于文章内容的问题,然后与人工标注的答案进行比对,得出精确匹配(Exact Match)和模糊匹配(F1-score)的结果。

▲ SQuAD挑战赛主页

▲ SQuAD挑战赛主页

SQuAD向参赛者提供训练集用于模型训练,以及一个规模较小的数据集作为开发集,用于模型的调优和选型。与此同时,SQuAD还提供了一个开放平台供参赛者提交自己的算法,由SQuAD官方利用隐藏的测试集对参赛系统进行评分,并在SQuAD官方确认后将相关结果更新到官网上。得益于SQuAD提供的大规模高质量的训练数据以及层出不穷的模型,该挑战赛的榜单一次又一次刷新。目前,科大讯飞与哈工大的联合实验室提交的系统模型取得了精确匹配77.845%和模糊匹配85.297%的成绩,位列世界第一。

科大讯飞是怎么考到全球第一的?

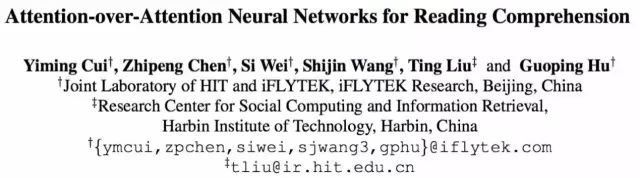

在SQuAD官网的成绩榜单上,可以看到科大讯飞与哈工大联合实验室提交的模型名为“InteractiveAoA Reader”,这是讯飞经过不断摸索之后提出的“基于交互式层叠注意力模型”(Interactive Attention-over-Attention Model)。正是这个与众不同的模型,让科大讯飞在全球自然语言理解研究领域脱颖而出跃居头名。

▲ 2016年,哈工大讯飞联合实验室发表了本次参赛模型的早期版本

▲ 2016年,哈工大讯飞联合实验室发表了本次参赛模型的早期版本

机器阅读理解问题的解决,传统的自然语言处理(NLP)方式是采用分拆任务的方法将其分成问题分析、篇章分析、关键句抽取等一些步骤,但这种方法容易造成级联误差的积累,很难得到很好的效果。

目前在机器阅读理解领域中,则多采用完全端到端的神经网络建模,消除了分步骤产生的级联误差。除此之外,采用神经网络的方法能够通过大量的训练数据学习到泛化的知识表示,对篇章和问题从语义层面上高度抽象化。

讯飞同样也采用了端到端的神经网络模型,但把精力更多放在如何能够模拟人类在做阅读理解问题时的一些方法。讯飞提出的基于交互式层叠注意力模型,主要思想是根据给定的问题对篇章进行多次的过滤,同时根据已经被过滤的文章进一步筛选出问题中的关键提问点。这样“交互式”地逐步精确答案的范围,与其他参赛者的做法不太相同,最终收获了令人瞩目的成绩。

此前,哈工大讯飞联合实验室曾先后在Google DeepMind阅读理解公开数据测试集、Facebook阅读理解公开数据测试集取得世界最好成绩,本次在SQuAD测试集再获全球最佳,包揽了机器阅读理解权威测试集的“大满贯”。

机器阅读理解技术拥有广阔的应用场景,例如在产品的精准问答、开放域的问答上都会起到有力的支撑作用,讯飞也在不断探索机器阅读理解技术的应用落地。但对于机器阅读理解的“能理解会思考”的终极目标来说,现在还只是万里长征的开始,对自然语言的更深层次的归纳、总结、推理,一定是未来机器阅读理解不可缺少的部分。

Nothing special